Système de vérification d’images iCloud et iMessage : Apple publie sa FAQ

La firme californienne cherche à rassurer ses utilisateurs face à une inquiétude montante concernant ses nouveaux outils mis en place pour améliorer la détection de contenus sexuels et pédopornographiques.

La firme californienne est prise dans une tempête de critiques et d’incompréhension après avoir annoncé la mise en place de nouveaux outils de surveillance de contenus. Ceux-ci veulent notamment permettre au Californien de repérer toute image à caractère pédopornographique et ainsi identifier les utilisateurs partageant ces contenus, une pratique évidemment illégale, aussi bien en France qu’aux États-Unis et ailleurs dans le monde.

Si la volonté d’Apple peut être initialement de bonne intention, avec cette lutte pour la protection de l’enfance, beaucoup s’inquiètent des dérives potentielles de ce qui s’apparente comme un premier pas vers une surveillance de masse des utilisateurs.

Alors, pour tenter de rassurer, la société a publié il y a peu une FAQ ou foire aux questions spécialement centrées sur ce nouveau système de protection de l’enfance. Voici ce qu’on y a apprend.

De quels outils est-il question ?

Apple précise dans sa FAQ que ce nouveau système de protection de l’enfance est en fait sous-tendu par deux outils, à ne pas confondre donc : l’avertissement contre les contenus à caractère sexuel dans iMessage et la détection de contenus pédopornographiques dans iCloud, surnommée CSAM pour Child Sexual Abuse Material.

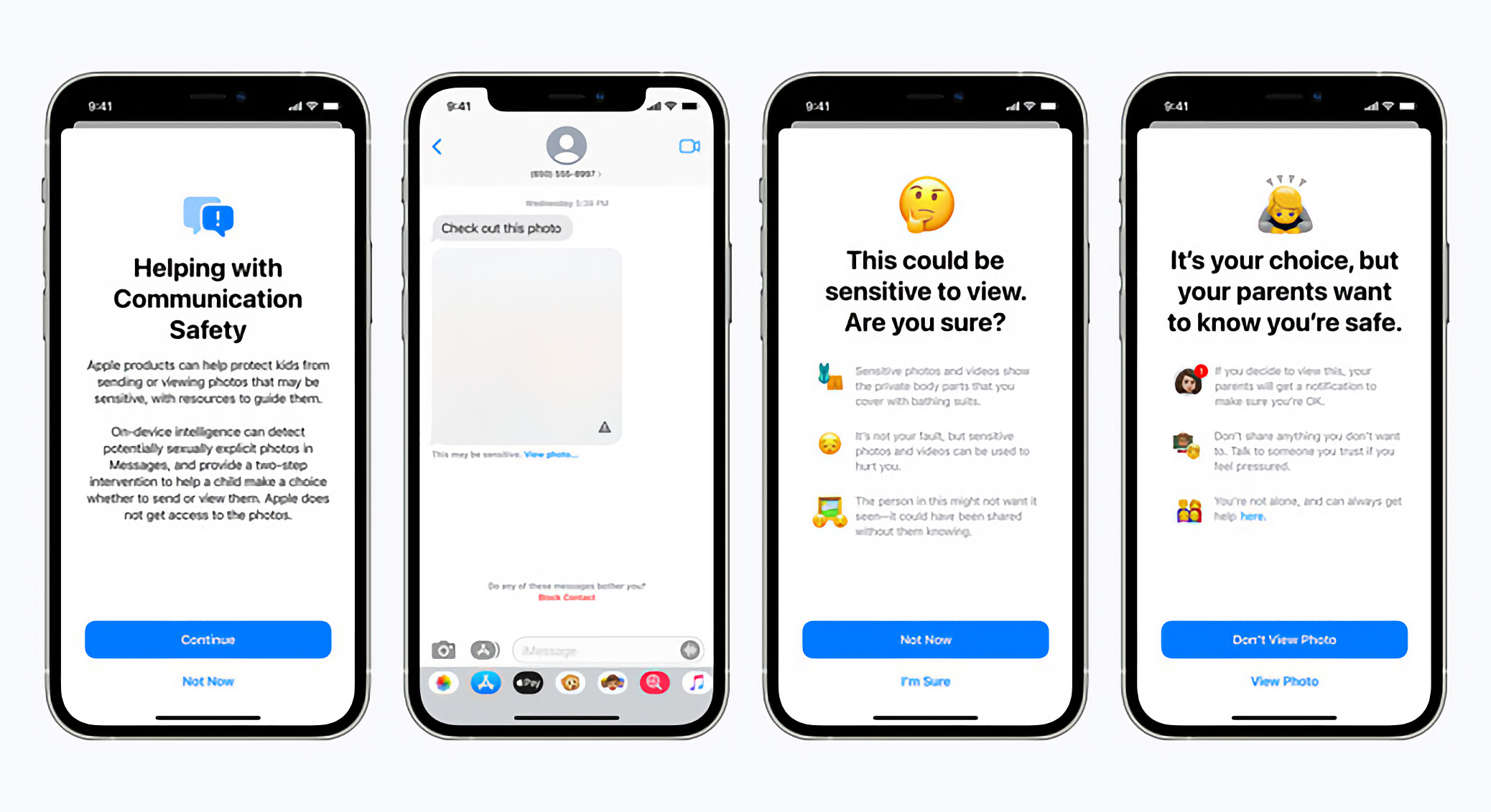

Outil d’avertissement d’images à caractère sexuel

Exclusifs aux photos iMessage

Comme précisé ci-dessus, le premier des deux outils est un mécanisme d’avertissement d’images à caractère sexuel. Il se concentre sur les images envoyées par iMessage, avec une analyse faite localement, sur la machine. Il est actif sur tout compte enfant configuré via le partage familial et peut être désactivé par l’utilisateur qui en a les droits, un parent généralement. Il veut servir à prévenir les enfants avant que ces derniers accèdent à une photo à caractère sexuel pouvant les choquer. Quand actif, l’outil floute toute photo sensible et l’enfant est averti. Une option permet également d’avertir un parent quand un enfant consulte une image repérée par cet outil.

© Apple

Comme le précise Apple, cet outil ne remet pas en cause le chiffrement bout-en-bout sous-tendant iMessage. Ainsi, à aucun moment la société n’accède aux contenus des échanges iMessage. L’analyse de l’image se fait uniquement depuis l’appareil servant à ouvrir l’image, en bout de l’échange, et en local, rappelons-le.

En outre, Apple dit ne partager aucune information de détection d’image à caractère sexuel dans ce cadre-là à aucune autorité.

Outil de détection de contenus à caractère pédopornographique CSAM

Le second outil est un mécanisme de détection d’images pédopornographiques. Il n’est actif que sur les photos iCloud. Voir le détail ci-dessous.

Quels contenus sont analysés par le CSAM ?

L’analyse des contenus du CSAM ne se fait que sur les photos et non les vidéos. En outre, seules les photos téléchargées sur iCloud sont prises en compte. Si vous n’utilisez pas la sauvegarde iCloud, vos photos ne passent donc pas dans l’outil de vérification d’images pédopornographiques d’Apple.

Le CSAM n’analyse pas les photos de votre photothèque locale sur l’iPhone ou l’iPad, ni les contenus iMessage. Il n’y a de ce fait pas de violation du chiffrement de bout-en-bout du service de texte Apple. Quant à la vie privée sur iCloud, c’est une autre question.

Est-ce qu’un humain consulte les images iCloud ?

Pas systématiquement. Une image à caractère pédopornographique est détectée sur l’espace iCloud d’un utilisateur à l’aide d’une intelligence artificielle et d’une comparaison faites avec des banques d’images déjà existantes de la NCMEC (National Center for Missing and Exploited Children) et d’autres associations de protection de l’enfance.

Apple précise d’ailleurs en ce sens que les faux positifs sont extrêmement rares : moins de 1 par milliard par année, selon la firme.

Une fois qu’une image a été détectée par l’I.A., celle-ci s’expose alors à une analyse humaine permettant de valider ou invalider la détection. Apple garantit que les innocents n’ont rien à craindre.

Quelles conséquences pour une détection positive ?

Si après analyse humaine, un compte iCloud a bien été considéré comme contenant des images à caractère pédopornographique, la NCMEC est avertie. Les conséquences qui suivent cette alerte à la NCMEC ne sont pas connues cependant. Les autorités compétentes sont possiblement prévenues par la suite pour la gestion du dossier et de l’utilisateur repéré.

Une extension à d’autres contenus à l’avenir ?

La firme californienne assure que son système a été construit pour ne se concentrer que sur les contenus à caractère pédopornographique. En outre, elle précise qu’elle refusera toute demande gouvernementale visant à ajouter d’autres contenus dans le système de détection. Pour le géant de Cupertino, il ne s’agit là que de détecter les images à caractère pédopornographique, rien d’autre.

Une extension à des services tiers ?

Comme le rapporte MacRumors, Apple vise à ce que cette détection des images à caractère pédopornographique soit également déployée sur des outils tiers. On pense par exemple à WhatsApp, Instagram ou encore Google Photos. Mais à ce jour, ce n’est pas encore le cas. Seules les photos sur iCloud sont pour le moment concernées par l’analyse CSAM.

Siri et Spotlight aussi mis à contribution

Apple indique que Siri et la recherche Spotlight pourront également participer à cette lutte pour la protection de l’enfance, en affichant plus d’informations pratiques sur le sujet lors de demande Siri et de recherches Spotlight depuis l’iPhone et l’iPad.

© Apple

Des outils actifs à partir de quand ?

Ces fonctionnalités de détection d’images sexuelles et pédopornographiques seront mise en place dans iOS 15, iPadOS 15, macOS Monterey et watchOS 8 et versions ultérieures, à une date encore inconnue.

Abdulkarim Jean Bosco

11 août 2021 à 15 h 06 min

Mais Apple devrait revoir et ameliorer la capacité de la batterie des téléphones qu’il met sur le marché.

C’est choquant qu’une telephone ne parvient pas à durée 12heures une fois connecté.

Iphone are good smartphones but its battery still an issue for users